近期,科技界迎來了一項創(chuàng)新突破,數(shù)據(jù)智能領(lǐng)域的佼佼者Databricks推出了一種名為TAO(測試時自適應優(yōu)化)的新型大語言模型微調(diào)技術(shù)。這項技術(shù)通過整合無標注數(shù)據(jù)和強化學習,不僅大幅削減了企業(yè)成本,還顯著提升了模型性能。

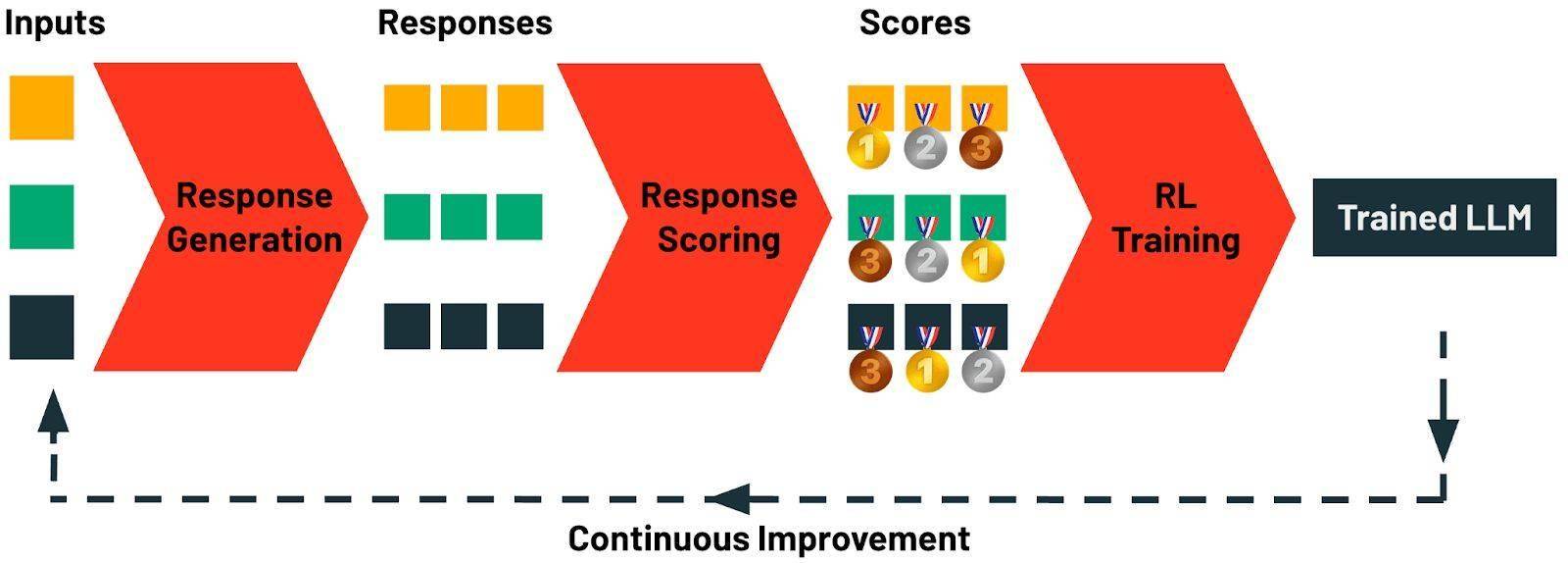

據(jù)悉,TAO方法的核心在于其獨特的測試時計算能力,能夠自動探索任務(wù)的各種可能性,并結(jié)合強化學習技術(shù)對模型進行優(yōu)化。這一過程省去了繁瑣的人工標注,使得企業(yè)在應用大語言模型時更加高效和經(jīng)濟。

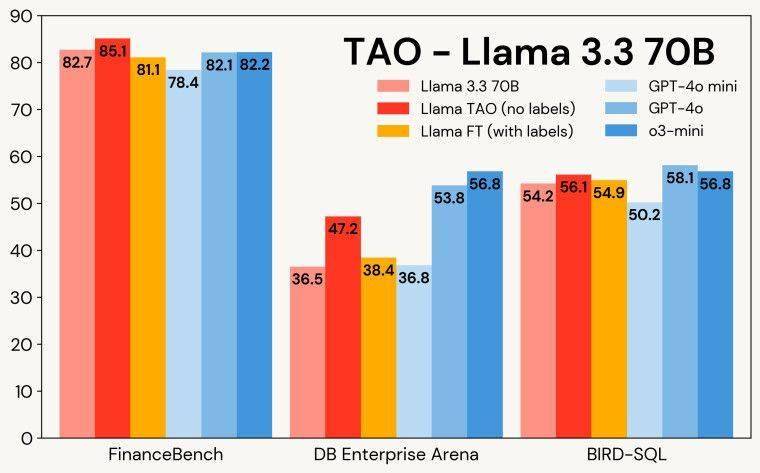

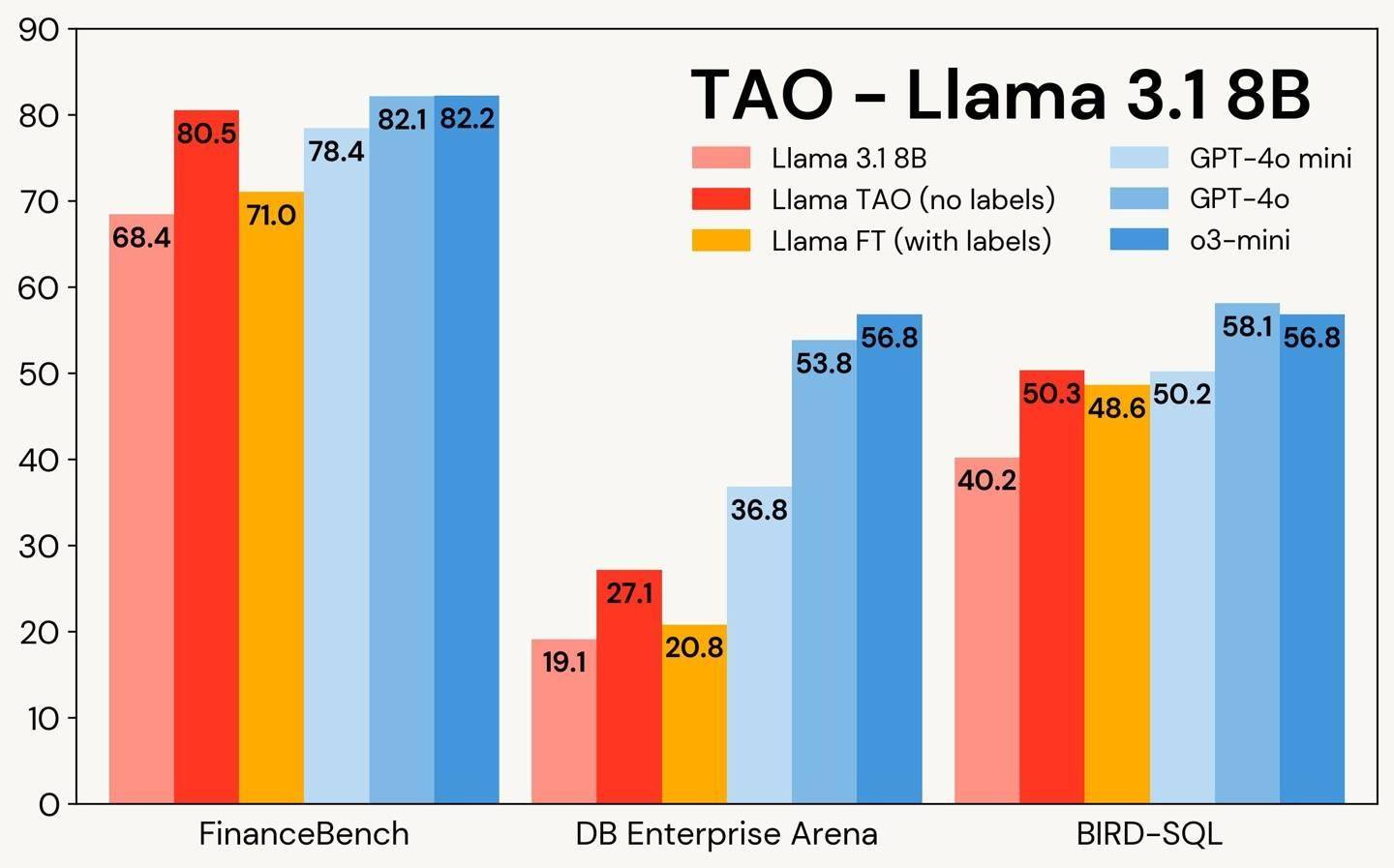

在實際測試中,TAO技術(shù)展現(xiàn)出了驚人的實力。以金融文檔問答和SQL生成任務(wù)為例,經(jīng)過TAO微調(diào)的Llama 3.3 70B模型,其表現(xiàn)甚至超越了傳統(tǒng)的標注微調(diào)方法,直逼OpenAI的頂級閉源模型。這一成果無疑為行業(yè)樹立了新的標桿。

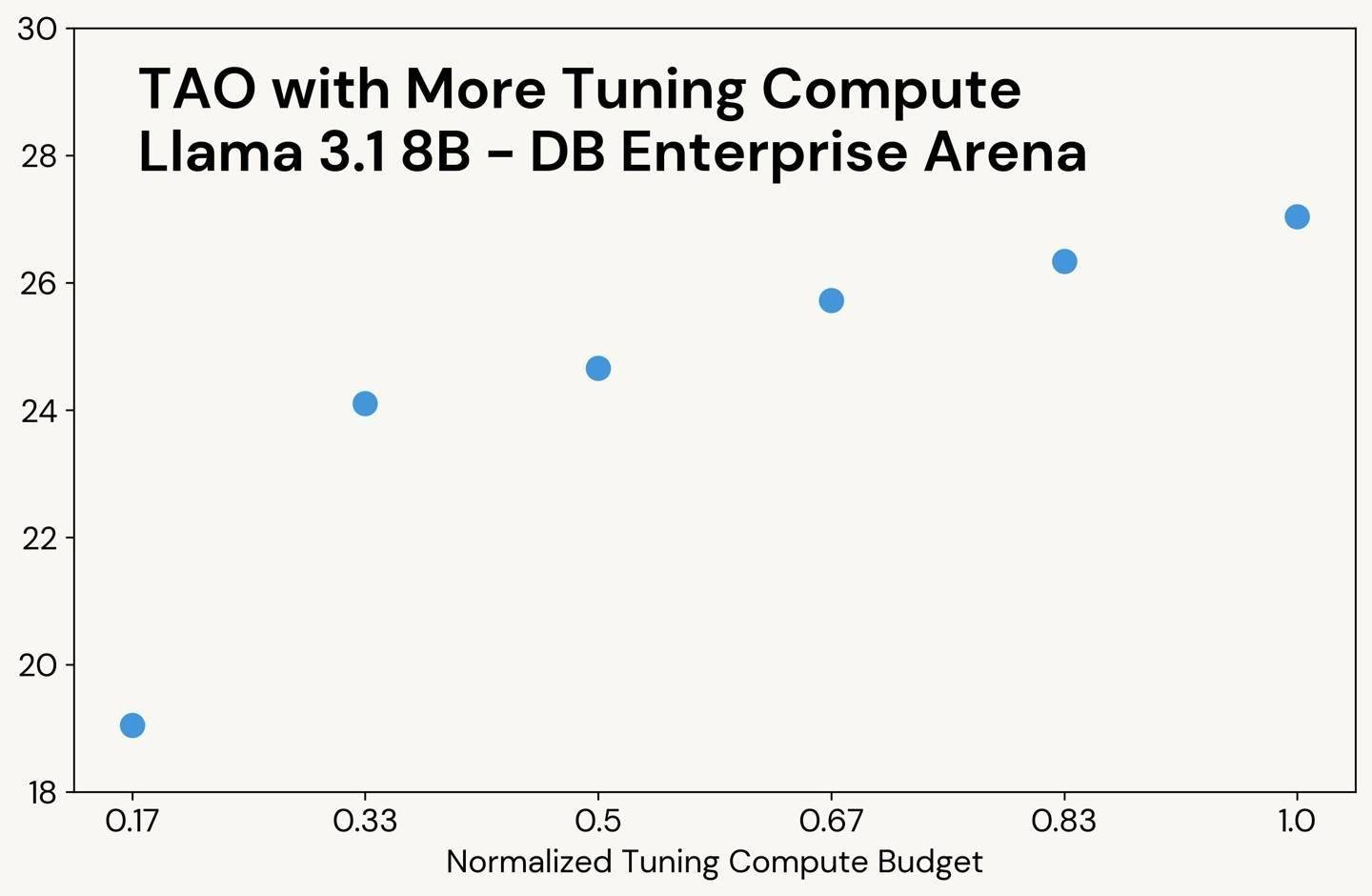

具體來看,在FinanceBench基準測試中,包含7200道SEC文檔問答的任務(wù)中,TAO模型以85.1的高分領(lǐng)先,優(yōu)于標注微調(diào)(81.1分)和OpenAI的o3-mini模型(82.2分)。在BIRD-SQL測試中,TAO模型同樣表現(xiàn)出色,以56.1分接近GPT-4o的58.1分,并遠超標注微調(diào)方法的54.9分。盡管在DB Enterprise Arena測試中,TAO模型以47.2分略低于GPT-4o的53.8分,但其整體表現(xiàn)依然令人矚目。

TAO技術(shù)的推出,不僅為開源模型提供了一條持續(xù)進化的路徑,還賦予了模型通過用戶反饋數(shù)據(jù)自我優(yōu)化的潛力。隨著用戶使用的增多,模型將不斷學習和改進,進一步提升其性能和適用性。

目前,TAO技術(shù)已在Llama模型上啟動了私密測試。企業(yè)用戶可以通過申請表單參與測試,率先體驗這一創(chuàng)新技術(shù)帶來的變革。隨著測試的深入和技術(shù)的不斷成熟,TAO有望在未來成為推動大語言模型應用發(fā)展的重要力量。