在今年的中國計算機大會(CNCC)上,參會者們不僅享受了一場科技盛宴,還意外地體驗了一把由AI帶來的便捷服務。大會舉辦地——橫店圓明新園,以其宏大的規模和精美的建筑,給所有參會者留下了深刻印象。然而,園區之大,也讓不少人感到腿酸腳痛。

面對這一挑戰,有人突發奇想:能否讓AI在橫店幫我們點一杯咖啡?這個想法很快得到了實現。在CNCC現場,智譜公司發布了其最新研發的自主智能體AutoGLM,這一功能強大的手機操作助手和瀏覽器助手,讓參會者們體驗了一把“動口不動手”的便利。

通過簡單的語音指令,AutoGLM就能打開美團,并根據指令點購咖啡,整個過程中,除了付款環節,完全不需要人的參與。這一功能不僅讓參會者們驚嘆不已,更讓他們在現場成功喝上了由AI點購的咖啡。

智譜公司此次發布的GLM-4-Voice情感語音模型,更是讓人眼前一亮。這一模型不僅擁有極高的響應速度和打斷速度,還能準確感知和共鳴用戶的情緒,其語音表達更是自然流暢,充滿了“活人感”。在實測中,GLM-4-Voice不僅在英語陪練和日語練習上表現出色,還能輕松駕馭北京腔、臺灣腔、東北腔和粵語等多種方言。

在CNCC的會場外,參會者們還帶著AutoGLM游覽了橫店知名景點“秦王宮”,并讓它以李白的身份即興作詩一首。小智不負眾望,創作了一首充滿豪情壯志的詩句,贏得了大家的陣陣掌聲。

除了情感語音助手外,智譜公司還在CNCC上展示了其在AGI(通用人工智能)技術路徑上的新思考。香港大學馬毅教授在大會主題圓桌論壇中提到,人類智能有兩個“原生大模型”:DNA和語言,它們都具備自我學習的能力。而當前的大模型雖然知識豐富,但在智能方面仍有不足。因此,要實現AGI,還需要在多模態、推理與自我學習等方面進行深入研究。

智譜公司的AutoGLM,正是其在工具能力上的新研究,也是其AGI實現路徑之一。通過端到端的語音模型,GLM-4-Voice避免了傳統級聯方案中的信息損失和誤差積累,實現了更高的建模上限。在預訓練方面,智譜將Speech2Speech任務解耦合為Speech2Text和Text2Speech兩個任務,并設計了兩種預訓練目標來適配這兩種任務形式。

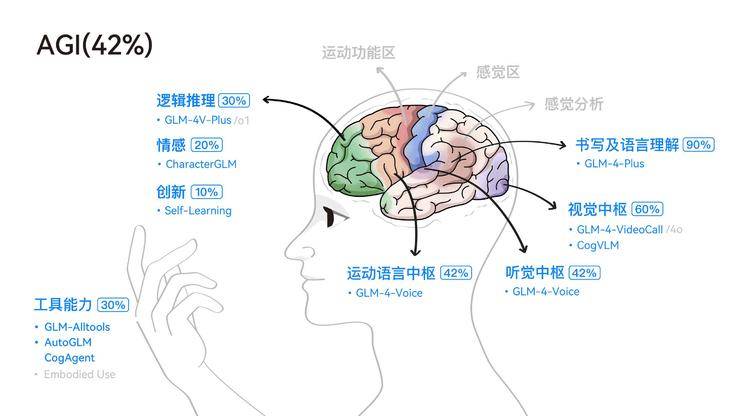

智譜公司還對AGI進行了深入的思考和探索。他們認為,盡管多模態是實現AGI的必經之路,但在多模態模型的研究中,仍需保持科學的懷疑和驗證精神。目前,多模態研究仍存在諸多挑戰,如不同模態之間的Gap、如何將不同模態結合起來等。

智譜公司的AGI路徑是先聚焦文本大模型的能力提升,然后再逐步擴展到圖像、視覺、語音等其他模態。他們不僅注重單一模態的單點能力提升,還注重雙模態、多模態的結合。目前,智譜的AGI研究已經超越了追趕OpenAI的階段,形成了一套自己的技術指南和路線圖。

在CNCC現場,智譜公司還透露了其即將推出的生成視頻模型CogVideoX的升級版本CogVideoX-Plus。這一新版本將支持60幀幀率、4K畫質、10秒時長、任意比例圖生視頻,并大幅提升運動穩定性。這一消息無疑為參會者們帶來了更多的期待和驚喜。

盡管距離AGI的實現還有很長的路要走,但智譜公司已經在這條路上邁出了堅實的步伐。他們的研究和探索不僅為AGI的發展提供了新的思路和方向,也為人工智能的未來發展注入了更多的活力和可能。